開(kāi)源賽道也是熱鬧了起來(lái)。

就在深夜,字節(jié)跳動(dòng) Seed 團(tuán)隊(duì)正式發(fā)布并開(kāi)源了 Seed-OSS 系列模型,包含三個(gè)版本:

Seed-OSS-36B-Base(含合成數(shù)據(jù))

Seed-OSS-36B-Base(不含合成數(shù)據(jù))

Seed-OSS-36B-Instruct(指令微調(diào)版)

Hugging Face 地址:

項(xiàng)目地址:

Seed-OSS 使用了 12 萬(wàn)億(12T)tokens 進(jìn)行訓(xùn)練,并在多個(gè)主流開(kāi)源基準(zhǔn)測(cè)試中取得了出色的表現(xiàn)。

這三個(gè)模型均以 Apache-2.0 許可證發(fā)布,允許研究人員和企業(yè)開(kāi)發(fā)者自由使用、修改和再分發(fā)。

主要特性:

靈活的推理預(yù)算控制:允許用戶(hù)根據(jù)需要靈活調(diào)整推理長(zhǎng)度。這種對(duì)推理長(zhǎng)度的動(dòng)態(tài)控制能力,可在實(shí)際應(yīng)用場(chǎng)景中提升推理效率。

增強(qiáng)的推理能力:在保持平衡且優(yōu)秀的通用能力的同時(shí),針對(duì)推理任務(wù)進(jìn)行了特別優(yōu)化。

智能體能力:在涉及工具使用和問(wèn)題解決等智能體任務(wù)中表現(xiàn)突出。

研究友好:考慮到在預(yù)訓(xùn)練中加入合成指令數(shù)據(jù)可能會(huì)影響后續(xù)研究,字節(jié)同時(shí)發(fā)布了含有與不含指令數(shù)據(jù)的預(yù)訓(xùn)練模型,為研究社區(qū)提供了更多樣化的選擇。

原生長(zhǎng)上下文:在訓(xùn)練中原生支持最長(zhǎng) 512K 的上下文窗口。

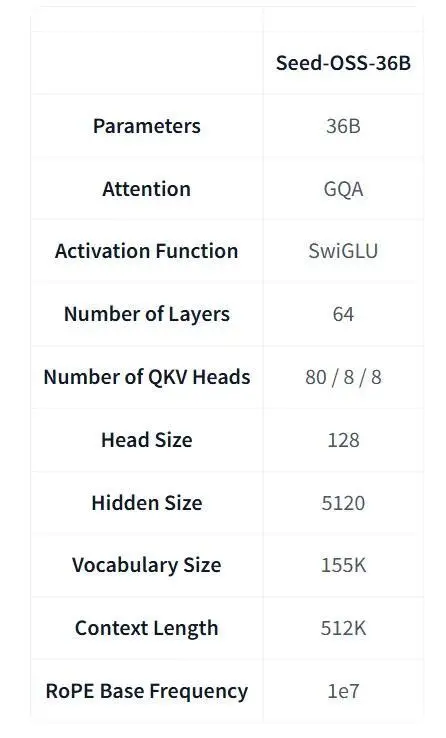

模型架構(gòu)

Seed-OSS-36B 的架構(gòu)結(jié)合了多種常見(jiàn)的設(shè)計(jì)選擇,包括因果語(yǔ)言建模、分組查詢(xún)注意力(Grouped Query Attention)、SwiGLU 激活函數(shù)、RMSNorm 和 RoPE 位置編碼。

每個(gè)模型包含 360 億參數(shù),分布在 64 層網(wǎng)絡(luò)中,并支持 15.5 萬(wàn)詞表。

其最具代表性的特性之一是原生長(zhǎng)上下文能力,最大上下文長(zhǎng)度可達(dá) 512k tokens,能夠在不損失性能的情況下處理超長(zhǎng)文檔和推理鏈。

這一長(zhǎng)度是 OpenAI 最新 GPT-5 模型系列的兩倍,大約相當(dāng)于 1600 頁(yè)文本。

另一個(gè)顯著的特性是引入了推理預(yù)算,它允許開(kāi)發(fā)者在模型給出答案之前,指定模型應(yīng)執(zhí)行多少推理過(guò)程。

這一設(shè)計(jì)在近期其他一些開(kāi)源模型中也有所體現(xiàn),例如 Nvidia 新推出的 Nemotron-Nano-9B-v2。

在實(shí)際應(yīng)用中,這意味著團(tuán)隊(duì)可以根據(jù)任務(wù)的復(fù)雜性和部署的效率需求來(lái)調(diào)節(jié)性能。

推薦的預(yù)算值為 512 tokens 的倍數(shù),其中 0 表示直接輸出答案的模式。

結(jié)果

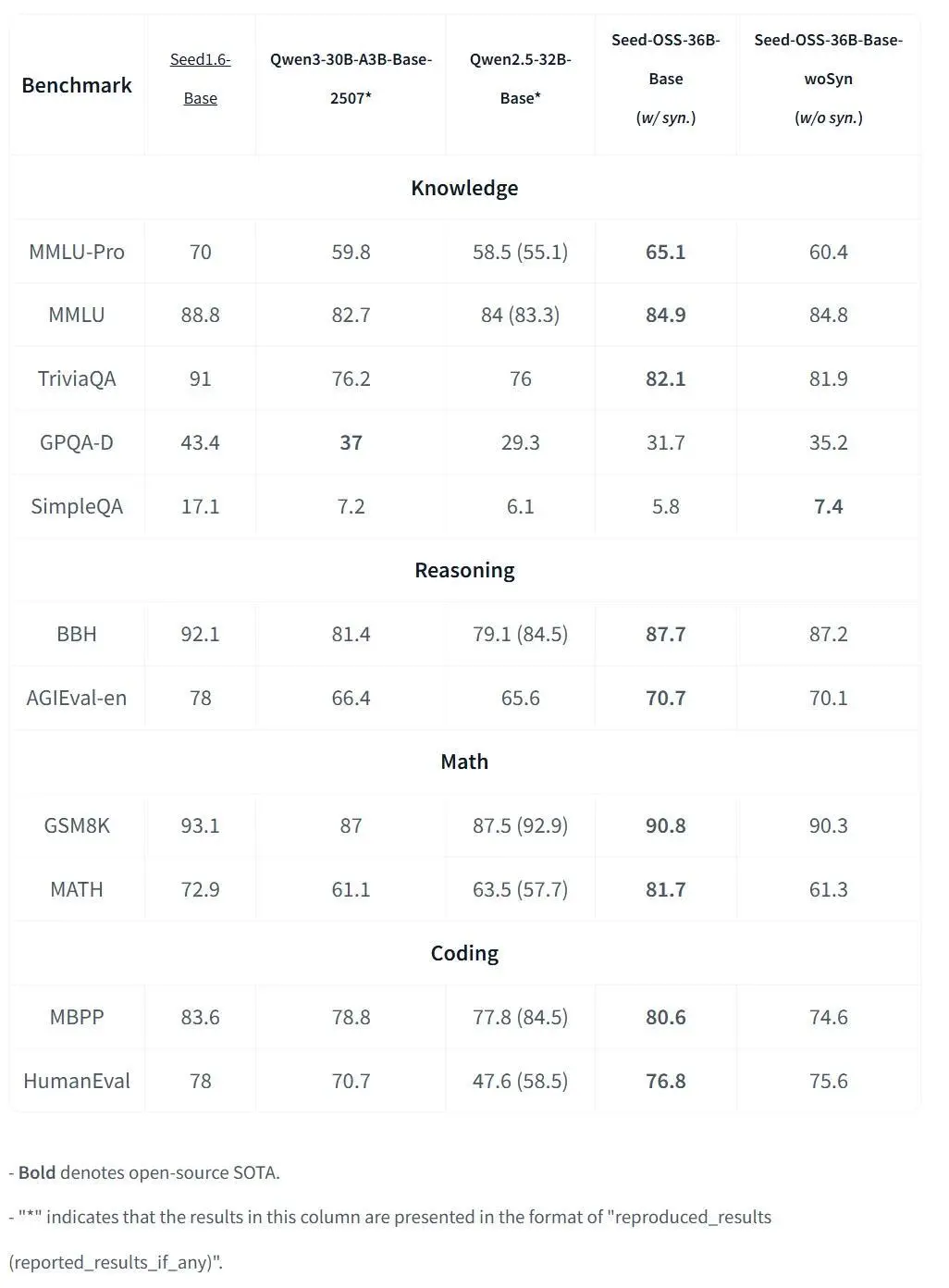

基準(zhǔn)測(cè)試結(jié)果顯示,Seed-OSS-36B 位列當(dāng)前性能較強(qiáng)的開(kāi)源大模型之列。

Seed-OSS-36B-Base

含合成數(shù)據(jù)版本的 Base 模型在 MMLU-Pro 上取得 65.1 得分,在 MATH 上取得 81.7 得分。非合成基礎(chǔ)版本雖然在許多方面略微落后,但也具有競(jìng)爭(zhēng)力。

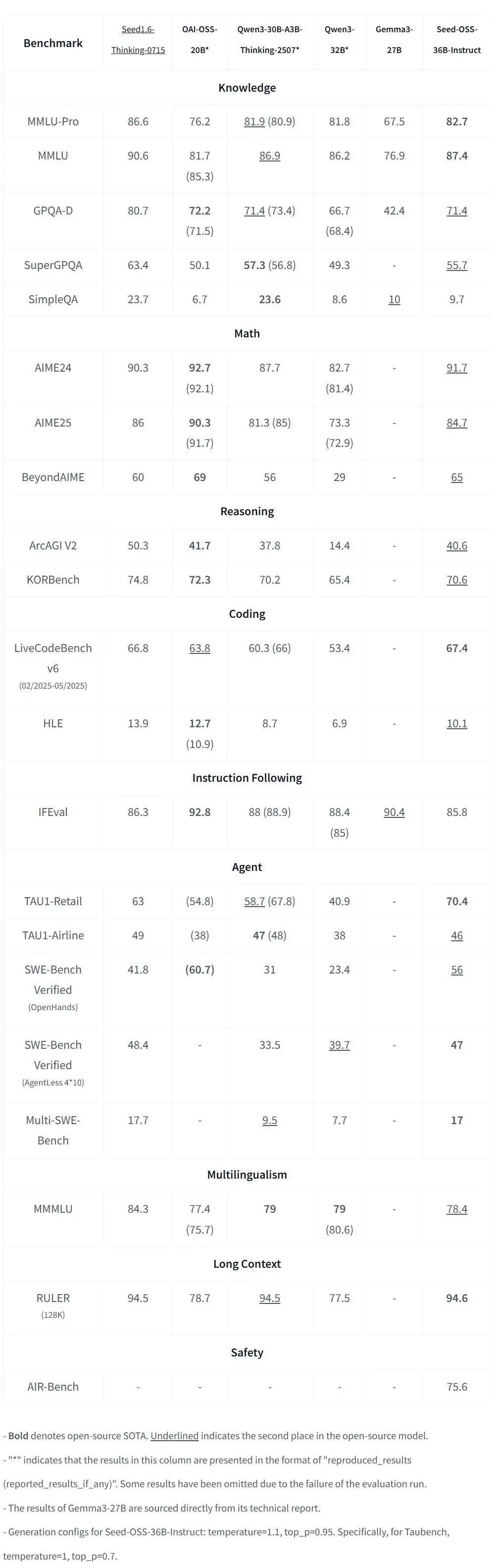

Seed-OSS-36B-Instruct

Instruct 版本在多個(gè)領(lǐng)域都取得了 SOTA 成績(jī)。

數(shù)學(xué)與推理:Seed-OSS-36B-Instruct 在 AIME24 上取得 91.7% 的成績(jī),在 BeyondAIME 上取得 65,均代表開(kāi)源領(lǐng)域的最新 SOTA 水平。

代碼能力:在 LiveCodeBench v6 上,Instruct 模型得分 67.4,同樣刷新 SOTA 紀(jì)錄。

長(zhǎng)上下文處理:在 RULER(128K 上下文長(zhǎng)度)測(cè)試中,該模型達(dá)到 94.6,創(chuàng)下開(kāi)源模型的最高分。

思考預(yù)算

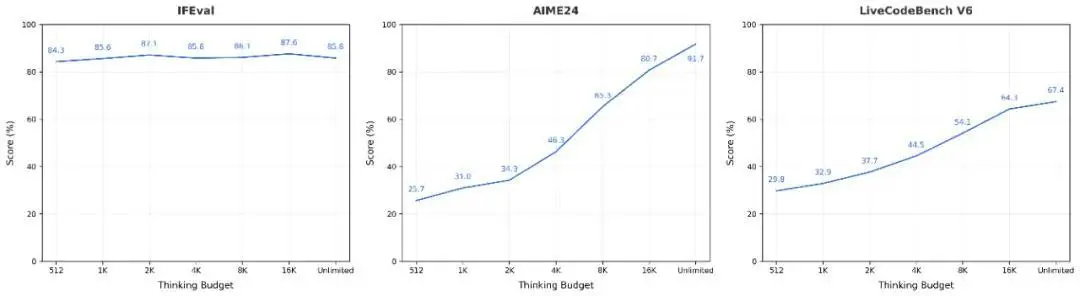

用戶(hù)可以靈活指定模型的推理預(yù)算。下圖展示了在不同任務(wù)中,隨著推理預(yù)算變化而產(chǎn)生的性能曲線。

對(duì)于較簡(jiǎn)單的任務(wù)(如 IFEval),模型的思維鏈較短,隨著推理預(yù)算的增加,分?jǐn)?shù)會(huì)出現(xiàn)一定波動(dòng)。

而在更具挑戰(zhàn)性的任務(wù)(如 AIME 和 LiveCodeBench)中,模型的思維鏈較長(zhǎng),分?jǐn)?shù)則會(huì)隨著推理預(yù)算的增加而提升。

模型在運(yùn)行過(guò)程,會(huì)提醒用戶(hù) token 使用情況。

如果未設(shè)置推理預(yù)算(默認(rèn)模式),Seed-OSS 將以無(wú)限長(zhǎng)度啟動(dòng)推理。

如果指定了推理預(yù)算,字節(jié)建議用戶(hù)優(yōu)先選擇 512 的整數(shù)倍數(shù)(如 512、1K、2K、4K、8K 或 16K),因?yàn)槟P鸵言谶@些區(qū)間上進(jìn)行了大量訓(xùn)練。

當(dāng)推理預(yù)算為 0 時(shí),模型會(huì)被指示直接輸出答案;對(duì)于低于 512 的預(yù)算,字節(jié)也建議統(tǒng)一設(shè)為 0。