時令 發自 凹非寺

大模型耗電驚人,輿論一浪高過一浪。

現在,谷歌用硬核數據強勢還擊。

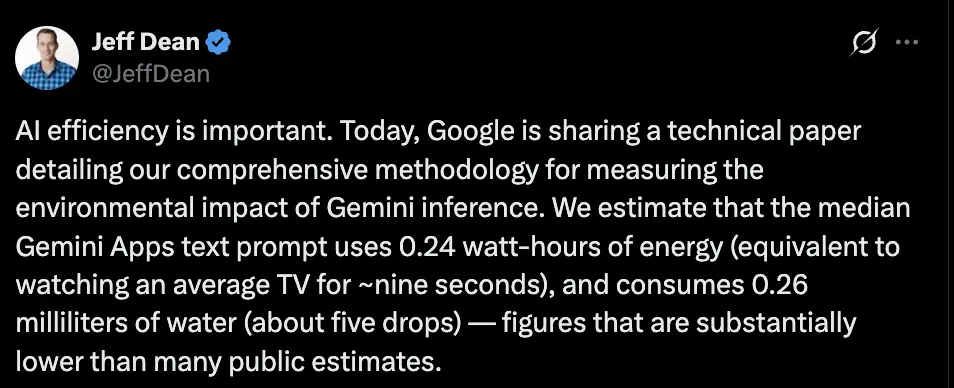

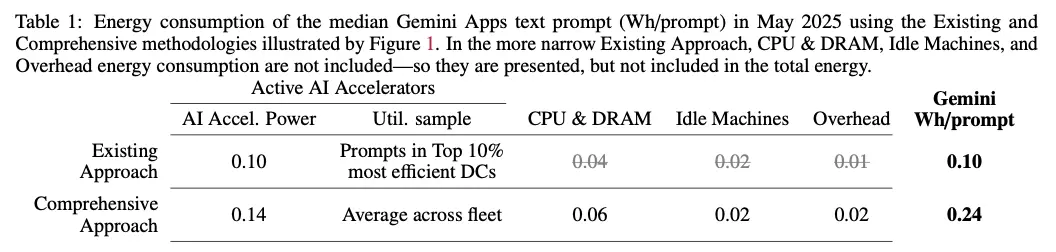

一次Gemini查詢僅能耗0.24wh,相當于微波爐運行1秒,排放0.03 g CO?e,甚至比人放一次屁還少,同時消耗約5滴水。

(文中數據均表示中位數)

谷歌首席科學家Jeff Dean公開表示:

這個數值明顯低于公眾普遍預期的水平。

并且像谷歌這樣的大模型廠商,一直專注研究如何降低AI消耗。

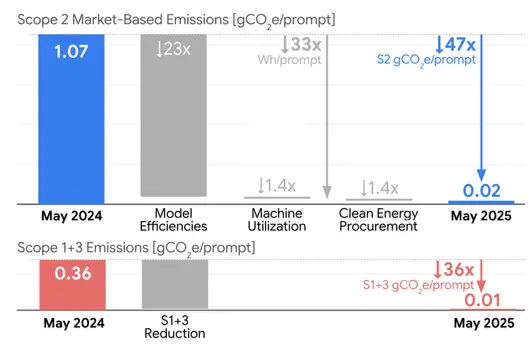

一年間,通過模型優化和額外清潔能源的使用,Gemini的能耗降至原來的1/33,碳排放降至1/44,同時提供了更高質量的響應。

下面讓我們一起看看谷歌是如何衡量和減少AI能源消耗的?

如何衡量AI消耗能源

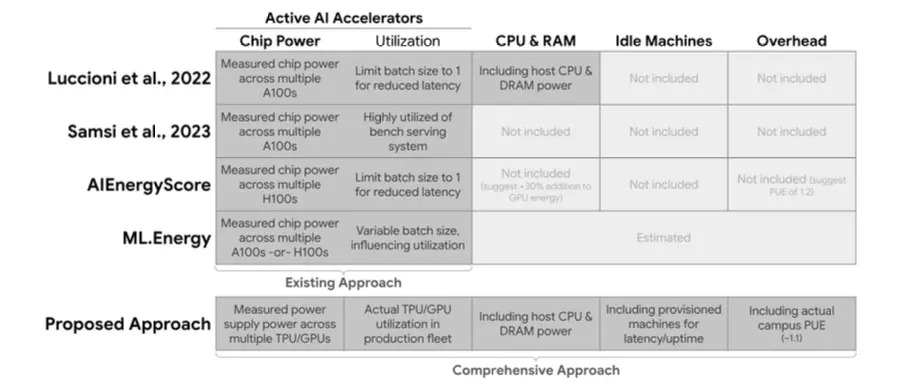

谷歌首先指出,目前許多關于AI能源消耗的計算反映的都是理論效率,而非大規模運行下的實際效率。

若Gemini只考慮TPU和GPU的消耗,一次查詢只需消耗0.10wh,排放0.02 g CO?e,耗水量約0.12ml。

但這種計算方式僅考慮了機器在運行中的能耗,而忽略了一些關鍵因素。

與此同時,Jeff Dean也表示:

人們都在思考AI是否會消耗大量能源?它是否會通過碳排放來傷害地球?

所以,谷歌針對AI服務時的實際情況,開發了一套更為全面的方法來計算能源消耗,包括以下幾個部分:

全系統動態功率

這不僅包括主AI模型在計算過程中使用的能源和水,還考慮了大規模運行下實際的芯片利用率,而該利用率往往遠低于理論最大值。

空閑計算機

為確保高可用性和可靠性,生產系統需要一定程度的預置容量,該容量處于空閑狀態,但隨時可以處理流量高峰或故障轉移。這些閑置芯片消耗的能量必須計入總能源足跡。

CPU和內存

AI模型的運行不僅依賴TPU和GPU等機器學習加速器,主機的CPU和內存同樣在提供服務和消耗能源方面起著關鍵作用。

數據中心開銷

運行AI的信息技術設備所消耗的能源僅占整體能耗的一部分。支撐這些計算的基礎設施,如冷卻系統、配電系統以及其他數據中心開銷同樣會消耗能源。這部分開銷能源通常用電力使用效率(PUE)指標來衡量。

數據中心用水量

為了降低能耗及相關排放,數據中心通常會使用水進行冷卻。隨著優化AI系統以提高能源效率,其整體用水量也會隨之自然減少。

通過上述更全面的指標,谷歌得出一次Gemini查詢的能耗為0.24wh,排放0.03 g CO?e,同時耗水量約5滴。

如此低的能耗,谷歌究竟是如何實現的?

為什么Gemini消耗這么低

谷歌表示,Gemin顯著的效率提升得益于其在AI開發中采取的全棧方法,從定制硬件、高效模型,到支撐這些模型運行的強大服務系統,他們在每一層都融入了效率優化。

首先是更高效的模型架構,Gemini是谷歌研究人員開發的Transformer模型框架,相比之前的語言建模架構,其效率可提升10倍到100倍。

此外,他們還在模型設計中融入了像MoE和混合推理等機制,從而進一步減少計算量和數據傳輸,提高整體運行效率。

與此同時,Gemini通過精準量化訓練(AQT)等方法不斷得到優化,使模型在保證回答質量的前提下進一步降低了能源消耗。

在優化推理和服務上,谷歌不斷改進AI的交付方式,以提升響應速度和整體效率。

比如通過推測解碼技術,較小的模型可以先進行預測,再由較大的模型快速驗證,從而用更少的芯片提供更多響應。

蒸餾技術則可以利用大型模型作為教師,生成用于服務的小型高效模型(如Gemini Flash和Flash-Lite)。

不僅如此,為了減少能耗,谷歌在硬件上還采用定制化。

十多年來,他們一直從零開始設計TPU,以最大化每瓦的性能。同時,他們還協同設計AI模型與TPU,確保軟件充分利用硬件潛力,硬件也能高效運行未來的AI軟件。

值得一提的是,最新一代TPU Ironwood的能效比首款公開TPU高30倍,在推理任務中遠超通用CPU。

接下來,就是優化空閑資源。谷歌的服務堆棧能夠高效利用CPU,并根據需求近乎實時地動態調度模型,從而最大化減少TPU的空閑時間,而不是采用“設置一次、永久運行”的方式。

同時,他們的XLA ML編譯器、Pallas內核和Pathways系統,使得在JAX等高級系統中表達的模型計算能夠在TPU服務硬件上高效運行。

再來看谷歌的超高效數據中心,其整體平均能源使用效率(PUE)可達1.09,為業界最高效的數據中心之一。

最后在數據中心運營方面,谷歌持續增加清潔能源的使用,以實現全天候無碳運行的目標,同時努力補充辦公室和數據中心平均消耗的120%淡水。

此外,他們還優化冷卻系統,通過科學的流域健康評估,平衡能源、水資源和排放之間的局部權衡,從而指導冷卻方式的選擇,并在水資源緊張地區限制用水量。